猫鱼周刊 vol. 042 NLP 已死?

编辑

关于本刊

这是猫鱼周刊的第 43 期,本系列每周日更新,主要内容为每周收集内容的分享,同时发布在

博客:阿猫的博客-猫鱼周刊

RSS:猫鱼周刊

邮件订阅:猫鱼周刊

微信公众号:猫兄的和谐号列车

文章

为什么 wordfreq 不会再更新了

项目wordfreq作者关于项目不再更新的公告。wordfreq 是一个 Python 包,其能查询某一个词在某个语言中的出现频率。

作者认为,生成式 AI 在 2021 年以后已经开始污染互联网上的文字,同时由于数据获取的难度和成本增加,以及传统的 NLP 实际上已经被生成式 AI 挤压得没有发展空间,再去投入这个项目已经没有意义了。

说起这个事情我还有一点点感触,因为我的大学很大部分时间花在了 NLP 上,那是 2018 年左右。NLP 有非常多细分的场景和方向,例如文本分类、信息抽取、机器翻译、问答等等,每个方向有一些独特的核心问题和解决方案,可以说是「百花齐放」。当然 GPT 2 在 2019 年推出的时候,也引起过一定的注意,但它当时只是一个「文本生成」的模型,对标的是当时的 BERT,时间也正是「预训练」兴起的时候。当时解决很多 NLP 问题都只需要在 BERT 后面再糊一层网络,就能获得不错的效果;如果有领域的语料,那就用 BERT 再微调一下。bert-base 的参数量只有 110M 左右,在一块 2060 上就可以运行,因此实验室的机器配一张 2080 已经足够跑实验,而普通学生也可以用相对便宜的显卡就能做对应的学习。

毕业之后,GPT 3.5 推出了,它比之前的模型相比,能生成更长的内容,到后来更是出现了 16k 乃至现在 100M 的上下文长度(相比之下 BERT 仅有 512)。很多事情变得不一样了,可以用模型生成大段大段的文本了,一些需要大量标注数据的应用(例如分类)可以通过简单的 prompt 工程解决了,原本复杂的领域问答也可以通过 RAG 来完成了。可以说传统的 NLP 被浇了个透心凉,过去「小而美」的解决方法被「力大砖飞」替代了,更大的参数量更多的训练语料使得 LLM 能轻松解决过去难以解决的问题。但是现在再要研究 NLP,或者说 LLM,就需要多卡才能完成实验,再不是当年一块 2080 就可以打比赛的程度了,更别谈个人甚至普通高校怎么获得这种计算资源或者语料资源的问题。

之前经常有人把 NLP 的发展概括成这么几个阶段:基于规则、基于统计学习以及基于深度学习,现在我想在后面再增加一个——基于大语言模型。这个新阶段有很鲜明的特征,例如底层模型的开发和训练需要大量的资源(约等于钱),因此底层模型的开发牢牢控制在商业公司和大型研究机构上,但是技术落地和普及相对更加简单(普通开发者通过 API 即可调用大语言模型,普通人可以在平常 APP 中用到 AI 相关的功能)。

是真的,就找找乐子

经常有人会问:

- 你为什么做这个?

- 你做这个有什么用?

- 你的项目跟 X 比起来怎么样?

其实很多时候,hacker 纯粹是喜欢写代码,喜欢软件构建的过程,并不是为了赚钱、为了别人的赏识,他们乐意花时间在键盘上敲敲打打,而并不介意在这上面创造了多少价值。

我的 GitHub Profile 上有写,Code for fun, and for ever.,就是这样的心态。

项目

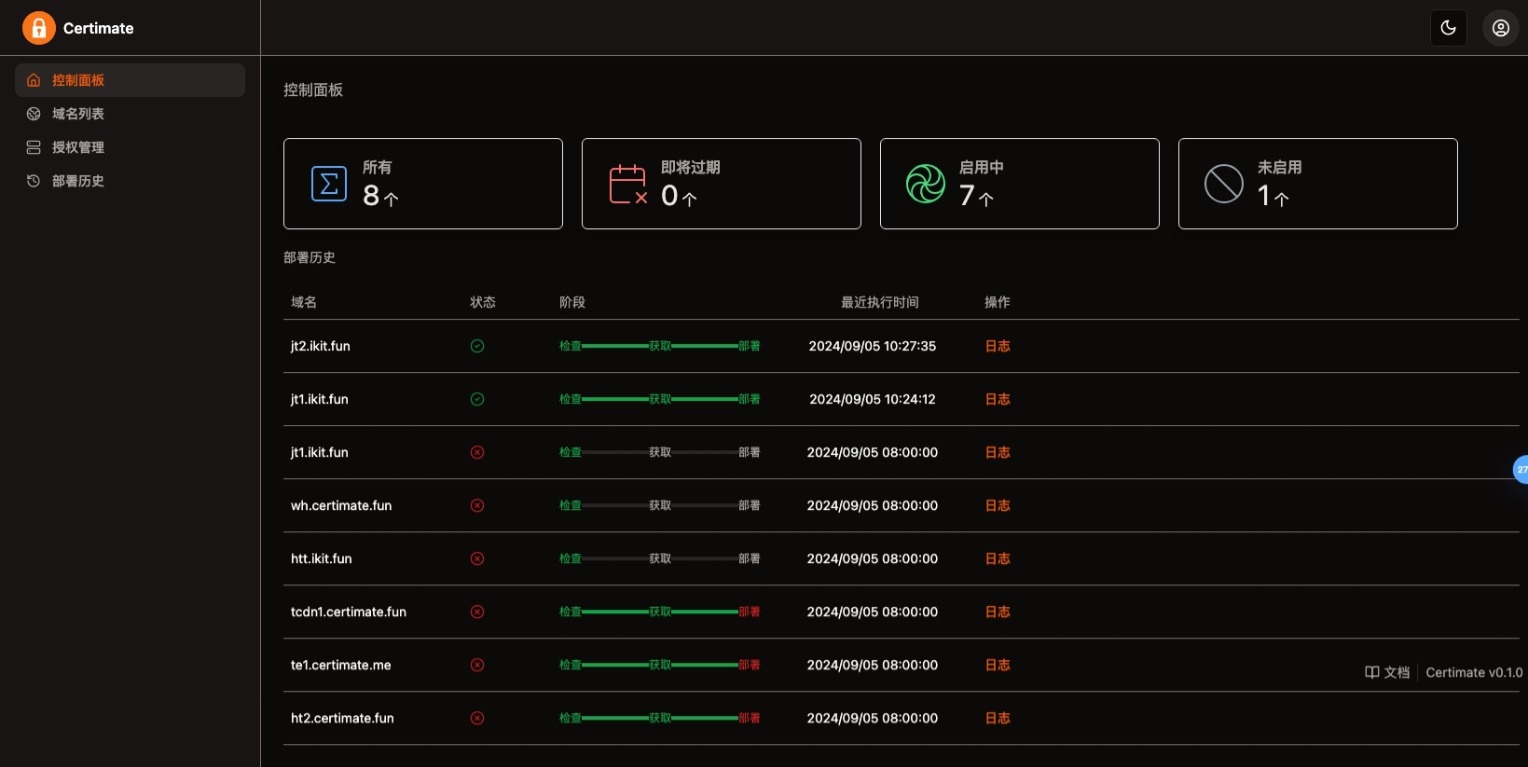

certimate

开源的 SSL 证书管理工具,可以帮助你自动申请、部署 SSL 证书,并在证书即将过期时自动续期。还挺适合个人使用的,再搭配上 uptime-kuma 来监控网站、证书过期,完美。

PrometheusAlert

开源的运维告警中心消息转发系统,支持从 Prometheus 等支持 WebHook 的监控系统,转发到多种 IM、电话短信等渠道。调研消息通知的时候碰到的,比较适合企业使用,个人用有点繁琐了。

工具/网站

they can talk

无厘头动物漫画,甚至有 RSS!

最后

本周刊已在 GitHub 开源,欢迎 star。同时,如果你有好的内容,也欢迎投稿。如果你觉得周刊的内容不错,可以分享给你的朋友,让更多人了解到好的内容,对我也是一种认可和鼓励。(或许你也可以请我喝杯咖啡)

另外,我建了一个交流群,欢迎入群讨论或反馈,可以通过文章头部的联系邮箱私信我获得入群方式。

- 1

- 1

-

赞助

微信赞赏码

微信赞赏码

-

分享